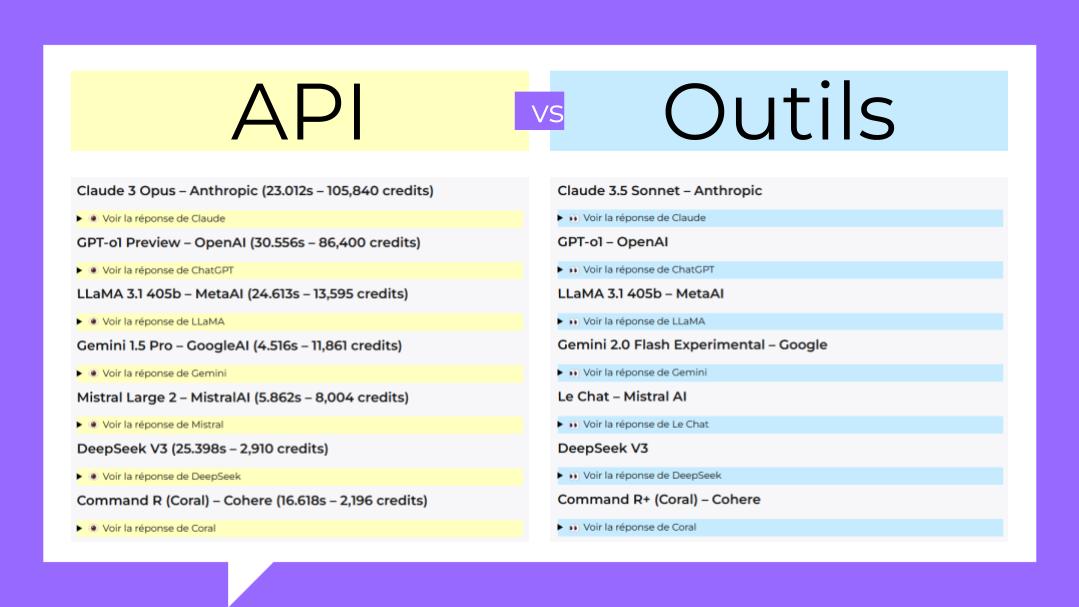

Ce petit comparatif a pour objectif de faire un très rapide état des lieux des principaux outils d’IA génératives à…

⭐ Évaluation collective ❔

| 🤖 Fonctionnalités | |

| 📱 Utilisabilité | |

| 🛡️Sécurité | |

| 💰 Prix | |

| 🎓 Alignement pédagogique | |

| 🐣 Maturité | |

|

Moyenne

|

|

|

|

![]()

🗨️ Vos retours libres

📢 On en parle sur l’ObsiaFormation

No Posts Found

📰 Actualités récentes depuis la source

ℹ️ Plus d’infos via Wikipédia

Présentation de Jean-Marc AIMONETTI (⏱️ 15 min)

Jean-Marc Aimonetti nous parle de son enseignement présentiel dans un amphi de 700 étudiants en L2 Psycho. Une des activités du contrôle continu proposée dans cet enseignement consiste à réaliser un mémoire par groupes de 4 étudiants sur un thème choisi parmi 12. Le travail doit être basé uniquement sur des articles anglophones référencés Pubmed. L’idée est d’aller plus loin que le cours magistral. Le protocole pédagogique est initialement présenté à l’ensemble de l’amphi via un tutoriel (PPT commentés) dont le but est de faire comprendre l’exercice demandé. Le scénario pédagogique est en trois étapes : premièrement, une validation de la bibliographie par l’équipe enseignant (optionnelle) ; deuxièmement, une validation du plan par l’équipe enseignant (optionnelle) et troisièmement, une évaluation du mémoire à partir d’une grille critériée pour l’autoévaluation par les étudiants eux-mêmes puis pour l’évaluation finale par l’équipe pédagogique. Lors de la première session (second semestre 22/23) l’absence d’un recul pédagogique sur les usages de ChatGPT par les étudiants, a rendu difficile la prise en compte du problème posé par l’émergence de ces nouveaux outils : l’équipe pédagogique a simplement décidé de modifier la grille critériée en changeant les pondérations des critères d’évaluation afin de pénaliser plus fortement les erreurs grossières typique d’un usage non raisonné de l’IA. En gros 1/3 des étudiants ont exclusivement utilisé ChatGPT (version gratuite) avec des résultats globalement moins bons. L’utilisation de ChatGPT est facilement reconnaissable : style plat, alimenté de lieux communs avec la présence d’hallucinations (fausses citations qui ne se retrouvent pas dans la bibliographie, invention de termes scientifiques, …). A noter que l’utilisation de la détection automatique des textes synthétiques par le système Compilatio (activable sur l’activité devoir d’AMeTICE) est peu concluante. [JMA] conclut que la traque aux textes synthétiques n’est probablement pas la bonne approche et qu’il est selon lui plus pertinent de proposer aux étudiants des méthodes pour une utilisation « intelligente » des IA génératives, c’est-à-dire d’encadre pédagogiquement la mise en place de stratégies efficaces pour amélioration la syntaxe et le style du mémoire, pour construire une bonne bibliographie, pour développer de bonnes pratiques d’utilisation des capacités de l’IA à produire des résumés, pour améliorer l’esthétique des illustrations avec les fonctionnalités texte-to-image,…

[JMA] revient la question l’évaluation en pointant l’évolution du poids des critères d’évaluation entre la Grille 2020 L2 Psycho et la Grille 2024 L2 Psycho. Pour le nouveau quadriennal, les équipes pédagogiques de L2 Psycho ont décidé un transfert du « savoir-faire rédactionnel » (qui passe d’un poids de 58% à 38%) vers le « savoir-faire académique » (qui passe d’un poids de 24% à 50%). Pour ce qui concerne la question de l’IA en formation, il faut noter la cohérence entre ce transfert et le constat d’une diminution potentielle (inéluctable ?) de l’importance des capacités rédactionnelles dans un contexte où les étudiants sont amenés à utiliser (dans un cadre pédagogique contrôlé ou de leur propre initiative) les IA génératives dans leurs productions écrites. Dans son propre travail de recherche, [JMA] a utilisé les capacités des IA génératives pour produire un résumé dans le cadre d’une édition scientifique : il constate l’efficacité de ces outils en termes de productivité (gain de temps) mais note la nécessité d’un travail de contrôle humain (correction des incohérences et des hallucinations qui sont toujours présentes). Mais les pièges qui attendent nos étudiants n’épargnent pas le monde de la recherche. Pour illustration, [JMA] termine avec une anecdote concernant la publication par une équipe de chercheurs chinois d’un article portant sur la spermatogenèse chez le rat. Cette publication a été retirée par l’éditeur après le constat de l’utilisation abusive des IA génératives par les auteurs, en particulier avec des illustrations complètement fantaisistes crées par une utilisation grossière de systèmes d’AI génératives text-to-image. Ces pratiques non déontologiques qu’on trouvent déjà dans le monde de la recherche vont bien sûr se développer dans les productions des étudiants : il y a là un problème global qui touche à la fois la recherche et la formation sur des thématiques très proches.

Support de la présentation

Deuxième présentation du SCD : Gaëlle LENFANT (⏱️ 19 min)

Gaëlle Lenfant nous présente une action du Service commun de la documentation (SCD) qu’elle a développée, spécifiquement en rapport à la sortie de ChatGPT. Cette action est construite autour des enjeux méthodologiques et porte sur l’usage de l’esprit critique face à des affirmations, généralement de nature scientifiques, relativement simples et idéalement non polémiques : deux exemples types qu’elle nous donne sont les suivantes : « les épinards sont une des meilleures sources alimentaires en fer » ou encore « la consommation de café arrête la croissance des enfants ». Cette action prend la forme d’un jeu de cartes où les questions sont posées et qui peuvent être distribuées à trois ou quatre équipes de 3 étudiants (ou personnels) : le jeu est pensé pour une modalité en présence (dans les BU d’AMU), mais la modalité en-distance est aussi possible et a été expérimentée avec succès. Chaque équipe a 5 min pour effectuer des recherches avec les outils de la BU et/ou via internet afin de se construire une opinion quant à la validité de l’affirmation énoncée sur leur carte. Chaque équipe doit alors présenter ses conclusions qui sont débattues avec l’ensemble des participants. Le maître du jeu possède les réponses aux questions qui sont débattues : à la fin, il est révélé que le jeu a été construit à l’aide de ChatGPT, ce qui pose le problème de la fiabilité des questions et des réponses qui sont proposées par l’IA et des méthodes de vérification des sources qui ont été mises en jeu pour corriger les réponses si nécessaire.

Support de la présentation

Le jeu : quiz des fake-news

Première présentation du SCD : Amélie GUARDIOLA et Élisabeth ANNEQUIN (⏱️ 15 min)

Le Service commun de la documentation (SCD) est en train de mettre à jour les ressources déjà développées autour de l’IA et projette d’en développer de nouvelles (en particulier une capsule sur les IA génératives). L’expertise des collègues du GT sur ces questions serait la bienvenue, dans le processus de production, en particulier pour la relecture des contenus afin de garantir un bon degré de pertinence. Amélie et Elisabeth nous décrivent les modalités de diffusion liées à ces ressources : celles-ci sont mises à disposition à la fois en formation (dans le cadre de l’UE MTU avec un cours sur AMeTICE sous la responsabilité des équipes enseignantes), mais aussi auto-formation en accès libre sous d’autres formats (en particulier un système pris en charge financièrement et techniquement par le SCD).

Support de la présentation

À propos de la démarche

En avril 2023, le gouvernement du Québec a confié au Conseil de l’innovation du Québec (ci-après le « Conseil ») le mandat de mener une réflexion collective non partisane, transparente et inclusive sur l’encadrement de l’intelligence artificielle (IA) au Québec.

Sous la direction de l’Innovateur en chef du Québec, monsieur Luc Sirois, le Conseil a rassemblé près de 250 experts pour se pencher sur six grandes thématiques. Il a récolté plus de 420 contributions en réponse à un questionnaire public sur l’encadrement de l’IA. Il a également organisé un forum public réunissant près de 1500 personnes pour échanger sur les orientations qui se sont dégagées des travaux de réflexion. Chacune des thématiques était codirigée conjointement avec un groupe de 15 responsables reconnus.

Le présent rapport est le fruit de ces travaux : il contribue à définir les enjeux et les possibilités que soulève l’IA. Il avance 12 recommandations prioritaires et 25 recommandations complémentaires visant à assurer le développement et l’utilisation responsables de cette technologie au Québec.

Une documentation complémentaire étoffée, incluant les rapports thématiques, les états de situation, le rapport d’analyse des contributions publiques et le rapport d’activités détaillant le processus mené par le Conseil, peut également être consultée sur le site Web du Conseil.

Le rapport

Toutes les publications

Présentation de Sophie PICARD (⏱️ 22 min)

Sophie Picard est DETU d’une licence ALLSH et s’intéresse à ce titre à l’évolution du premier cycle universitaire. Elle nous parle de ses expériences d’utilisation des IA génératives dans son enseignement en Licence LLCER allemand. Elle est depuis longtemps sensibilisée aux questions touchant le développement des IA, en particulier pour ce qui concerne les systèmes de traduction automatique [ces développements sont à l’origine de la technologie des « Transformers » — le « T » de « GPT » — à la base des IA génératives textuelles]

Sophie Picard commence par décrire son utilisation « naïve » des IA génératives dans ce contexte de formation. Elle pointe les difficultés (manque de temps) posées à un Enseignant-Chercheur afin de maintenir une veille technologique sur des outils soumis à de fortes évolutions.

Mais la nécessité de prendre en compte l’émergence des technologies d’IA génératives dans la formation lui a donné l’occasion de remettre (du moins pour le premier cycle) une forme d’expérimentation au coeur de son enseignement, aussi bien du point de vue enseignant que du point de vue étudiant : cette situation pourrait ainsi être l’occasion d’un retour des modalités de formation par la recherche, dont on constate une lente érosion dans la formation universitaire du premier cycle.

Au cours de l’année qui vient de s’écouler (depuis janvier 2023), ces expérimentations ont montré comment une co-construction pédagogique pouvait s’opérer entre enseignants et enseignés. Il faut noter que les séquences d’enseignements ayant utilisé les IA génératives ont naturellement pris une forme relevant des pédagogies actives : l’aspect expérimental a permis — aux étudiantes et à l’enseignante — d’apprendre à la fois hors d’un cadre prédéfini et dans une perspective ouverte.

Un des points de départ de la réflexion pédagogique de Sophie Picard est parti d’un constat sur les lacunes méthodologiques attachées à la lecture d’un texte : « si un texte possède d’apparentes qualités formelles, alors son contenu est nécessairement fiable ». Ce préjugé classique — qui sous-tend le problème de l’esprit critique — est réinvesti de manière frappante et originale à propos des textes synthétiques : ces derniers mélangent des qualités formelles (bonne syntaxe et cohérence sémantique) à des « hallucinations » parfois grossières, aussi bien qu’à des biais beaucoup plus insidieux (dus à la nature de ces IA et à leur paramétrage). Un vieux problème — exercer son esprit critique — est alors replacé dans un contexte technologique en forte évolution, posant à la fois de nouvelles questions et mettant en jeu de nouveaux risques (ou disons de nouvelles modalités pour les risques classiquement attachés à l’exercice de son esprit critique — e.g. les risques de désinformation). C’est dans cette situation inédite, que l’enseignante et les étudiantes ont été amenées à co-construire à la fois les modalités d’enseignement aussi bien que de nouvelles pratiques d’étude, les mettant de fait dans le contexte pédagogique expérimental déjà mentionné. Ces expériences pédagogiques avec ChatGPT, ont ainsi été l’occasion de renverser une situation déstabilisante, en transformant la remise en question de l’enseignement face à ces nouvelles technologies, en un prétexte pour réapprendre à lire, à analyser et à évaluer une production écrite.

En conclusion l’émergence des IA génératives dans l’étude et l’enseignement donne l’opportunité de replacer l’expérimentation au coeur de nos formations : en provoquant (au sein du groupe pédagogique) la discussion sur ce sujet, on observe que ce processus amène les étudiants à produire une réflexion éthique sur des questions qui non seulement les concernent, mais qui constituent aussi un défi pour les équipes pédagogiques. Aussi, dans cette co-construction des futurs possibles de la formation, il est important de ne pas oublier le rôle essentiel des étudiants.

Support de la présentation

La DRANE (Direction de Région Académique du Numérique pour l’Éducation) de la région PACA organise une veille et diffuse une newsletter sur l’intelligence artificielle depuis novembre 2021.

Présentée de manière accessible en 1 page chaque mois, elle contient en général au moins 1 activité, 1 ressource, 1 mythe à déconstruire, 1 webinaire, 1 application et 1 date.

Retrouvez tous les numéros sur le site des Académies d’Aix-Marseille et de Nice.

Vous pouvez également feuilleter tous les numéros de La Boite Noire de novembre 2021 jusqu’à janvier 2024 via ce flipbook/Calameo mis à disposition par la DRANE.

Retrouvez également d’autres ressources utiles du groupe académique « Intelligence Artificielle » composé d’enseignants de plusieurs disciplines et provenant des 4 départements de l’académie : IA dans la classe, tutoriels, Café IA, webinaires, etc.

Présentation de Marius BERTOLUCCI (⏱️ 22 min)

Depuis la sortie « grand public » de ChatGPT 3, un certain nombre d’outils/services d’IA génératives en libre accès ont été ouverts (BingIA, Bard-Gemini, Claude, PerplexityIA,…). Pour les IA génératives, un événement marquant de l’année 2023 a été la sortie de ChatGPT4 basé sur un modèle de langage significativement plus gros que GPT 3.5, accouplé à un ensemble de plugins (pour certain très performants) et maintenant couplé à certaines fonctionnalités multimodales comme GPT4-Vision basé sur Dall-E 3 (il s’agit de fonctionnalités text-to-image et image-to-text à un niveau de performance impressionnant). Le développement de ce système pose (entre autres) deux problèmes : il est d’une part un service payant (l’abonnement de base est à 20 $/mois), mais il est d’autre part très performant, en particulier sur des fonctionnalités clairement utilisables dans un contexte de formation universitaire. Il est important de prendre la mesure des impacts potentiels de ces outils « Premium » dans le contexte de l’enseignement universitaire.

Support de la présentation

Présentation de Nicolas MONTÈS (⏱️ 42 min)

Nicolas Montès nous présente une expérimentation pédagogique autour de la production d’un mini mémoire (deux groupes d’étudiants pour un total d’env. 50 étudiants) : il s’agit d’un travail personnel en groupe de trois se concluant par un oral de 15 min par groupe. Les sujets proposés sont choisis pour leur caractère controversé et la nécessité de les aborder avec un regard critique. Quelques exemples parmi d’autres :

- Consommer bio réduit-il de 25% les risques de Cancer ?

- Les compteurs Linky sont-ils dangereux pour la santé ?

- Les OGM sont-ils des poisons ?

- Le vaccin de l’hépatite B cause-t-il la sclérose en plaque ?

- 97% des denrées alimentaires contiennent-elles des résidus de pesticides ?

- L’électrosensibilité existe-t-elle ?

La méthode de travail proposée aux étudiants intègre l’utilisation d’IA génératives. Un ensemble d’outils d’IA génératives en accès libre est présenté aux étudiants ainsi que des méthodes de travail adaptées à ces nouvelles MTU (Méthode et Techniques Universitaires : travail sur le « prompting », travail sur les potentielles hallucinations par une vérification systématique, esprit critique, …). Il est demandé à chaque groupe d’accompagner le mémoire d’une annexe décrivant les méthodes de travail, spécialement avec les IA génératives (e.g. liste des prompts utilisés). Le statut de l' »Oral » est essentiel dans ce dispositif pédagogique et entraîne un coût en termes d’heures d’enseignement : ce point est significatif pour la question qui nous occupe. Le compte rendu du retour d’expérience du point de vue étudiant est particulièrement intéressant.

Support de la présentation

⭐ Évaluation collective ❔

| 🤖 Fonctionnalités | |

| 📱 Utilisabilité | |

| 🛡️Sécurité | |

| 💰 Prix | |

| 🎓 Alignement pédagogique | |

| 🐣 Maturité | |

|

Moyenne

|

|

|

|

![]()

🗨️ Vos retours libres

📢 On en parle sur l’ObsiaFormation

📰 Actualités récentes depuis la source

ℹ️ Plus d’infos via Wikipédia

DeepSeek

| Créateur | Liang Wenfeng |

|---|---|

| Première version | |

| Dernière version | |

| État du projet | Développement actif |

| Type |

Start-up Entreprise technologique (en) |

| Politique de distribution | Freemium |

| Site web | https://www.deepseek.com/ |

DeepSeek[a] (chinois simplifié : 深度求索 ; pinyin : ) est une société chinoise d'intelligence artificielle et le nom de son agent conversationnel, qui exploite un grand modèle de langage. Établie à Hangzhou, la société est fondée et soutenue par le fonds spéculatif chinois High-Flyer (en).

Début 2025, DeepSeek dévoile un agent conversationnel publié en open source sous licence MIT. Ce modèle, aux performances qui seraient comparables, voire supérieures, à celles des leaders américains, se démarque par son faible coût de développement et sa consommation réduite de ressources. La publication entraîne une réaction notable des marchés financiers. Les cours de plusieurs entreprises américaines, notamment ceux du leader mondial des puces graphiques utilisées dans l'intelligence artificielle Nvidia, enregistrent une forte baisse. Peu après, la société lance le modèle Janus-Pro-7B, qui génère des images à partir de prompt textuel, produit qui pourrait concurrencer DALL-E 3 d’OpenAI et Stable Diffusion.

Historique

Création et premiers modèles (2023-2024)

En , High-Flyer, fonds spéculatif basé à Hangzhou et employant un modèle d'intelligence artificielle pour le trading à haute fréquence[1], annonce par l'intermédiaire de son fondateur Liang Wenfeng lancer une entreprise indépendante spécialisée dans l'intelligence artificielle baptisée DeepSeek, pour développer et commercialiser une intelligence artificielle générale utilisant un grand modèle de langage développé par la firme[2].

En , DeepSeek lance son premier modèle, baptisé DeepSeek Coder et spécialisé dans la génération et la compréhension de codes sources[3].

Le de la même année, DeepSeek lance son premier agent conversationnel employant un grand modèle de langage unique baptisé DeepSeek LLM (à 67 milliards de paramètres, gratuit et open source[4]).

Le , DeepSeek sort DeepSeek-V2, comportant cette fois 236 milliards de paramètres, et pouvant activer jusqu'à 21 milliards de paramètres à chaque jeton utilisé[5]. Le mois suivant sort la deuxième version de DeepSeek Coder baptisée DeepSeek-Coder-V2[6].

En , DeepSeek sort DeepSeek-V3, qui remplace la version précédente et se veut une alternative chinoise aux autres modèles de langage disponibles en ligne[7],[8]. 256 grappes ("clusters") comprenant chacune 8 cartes graphiques H800 soit un total de 2048 cartes graphiques durant 5000 heures sont nécessaires pour la partie apprentissage fin supervisé et l'apprentissage par renforcement de DeepSeek-V3 soit au total un équivalent de 2.79 millions d'heures en carte graphique en utilisant des optimisations. Cependant des doutes subsistent concernant le fait qu'un nombre si faible de grappes ait été utilisé[9]. Après entrainement, il a été déployé aussi sur des grappes H800. Les cartes H800 d'une grappe sont connectées par interconnexion directe NVLink, et les grappes sont connectées par InfiniBand[10].

Percée mondiale (2025)

Le , l'entreprise annonce son premier modèle de raisonnement, DeepSeek-R1, qui emploie une chaîne de raisonnement développant des étapes logiques successives aux requêtes[11],[12],[13]. Le modèle, publié avec son code source sous licence MIT, bouleverse le secteur de l'IA par un coût de développement significativement moins élevé que ses concurrents pour des performances comparables aux meilleurs acteurs du secteur (bien que plus lent)[14], et une consommation en ressources de calcul notablement inférieure[15]. Face à la rentabilité présumée de la technologie, le cours de la bourse de plusieurs géants du domaine, (dont celui de Nvidia, le fournisseur de processeurs GPU, qui perd 600 milliards de dollars)[16], chute massivement[17],[18].

Modèles

| Versions majeures | Date de sortie | Variantes principales | Remarques |

|---|---|---|---|

| DeepSeek Coder | 2 novembre 2023 | Base (préentraîné) ; Instruct (avec fine-tuning par instructions) | L'architecture est essentiellement la même que Llama. |

| DeepSeek-LLM | 29 novembre 2023 | Base ;

Chat | |

| DeepSeek-MoE | 9 janvier 2024 | Base ;

Chat |

Utilise une variante de l'architecture mixture of experts (MoE). |

| DeepSeek-Math | Avril 2024 | Base | Initialisé avec DS-Coder-Base-v1.5 |

| Instruct | |||

| RL (Reinforcement Learning, ce qui signifie apprentissage par renforcement) | Implémente Group Relative Policy Optimization (GRPO), une variante de Proximal Policy Optimization (PPO). | ||

| DeepSeek V2 | Mai 2024 | DeepSeek-V2, DeepSeek-V2-Chat

DeepSeek-V2-Lite, DeepSeek-V2-Lite-Chat DeepSeek-Coder-V2 DeepSeek-V2.5 |

Intègre l'attention latente multi-têtes (MLA) et le système mixture of experts (MoE). |

| DeepSeek V3 | Décembre 2024 | DeepSeek-V3-Base

DeepSeek-V3 (un modèle de chat) |

L'architecture est essentiellement la même que V2. |

| DeepSeek R1 | 20 novembre 2024 | DeepSeek-R1-Lite-Preview | Accessible uniquement via API et une interface de chat. |

| 20 janvier 2025 | DeepSeek-R1

DeepSeek-R1-Zero |

Initialisé à partir de DeepSeek-V3-Base et partageant l'architecture V3. | |

| Modèles distillés | Initialisés à partir d'autres modèles, tels que Llama, Qwen, etc. Distillés à partir de données synthétisées par R1 et R1-Zero. |

Critiques

Sous-estimation des coûts

Le budget annoncé de 5,57 millions de dollars, spécifiquement alloué à un seul cycle d'apprentissage de DeepSeek V3, exclurait d'autres dépenses significatives telles que les salaires du personnel, les coûts liés au traitement des données, ainsi que ceux associés à la conception et à l'architecture du système[19].

En outre, l'entraînement du modèle DeepSeek nécessiterait environ 2 048 cartes graphiques Nvidia H800, une version bridée du H100 développé par la même société et destinée à l'exportation en Chine. Avant les restrictions imposées par l'administration de Joe Biden au début de l'année 2025, le coût de ce matériel était estimé à environ 70 millions de dollars[19]. Par ailleurs, les dépenses annuelles consacrées à ce projet seraient évaluées entre 500 millions et 1 milliard de dollars[20].

Allégations de détournement de l’interface de programmation d’OpenAI

En janvier 2025, OpenAI et Microsoft soupçonnent DeepSeek d'avoir utilisé un processus de distillation des connaissances pour extraire des données des modèles d'OpenAI via son interface de programmation, en violation de ses conditions d'utilisation. Le modèle répondant même à des questions du type « Qui es-tu? » par « Je suis ChatGPT »[21].

Microsoft dit avoir détecté fin 2024 d'importants transferts de données via des comptes développeurs OpenAI présumés liés à DeepSeek. OpenAI affirme détenir des preuves de ces pratiques, sans toutefois les détailler publiquement, et indique collaborer avec le gouvernement américain pour protéger sa propriété intellectuelle[22],[23],[24].

Stockage des données

Selon sa politique de confidentialité, DeepSeek stocke les données utilisateur sur des serveurs situés en République populaire de Chine, y compris l'historique des conversations et les informations personnelles de ses utilisateurs[25]. L'entreprise est tenue de collaborer avec les autorités chinoises conformément à la loi sur le renseignement national, ce qui suscite la préoccupation du professeur d'informatique britannique Michael Woodridge[26] et du ministre australien des Sciences, Ed Husic (en)[27].

Censure

Soumis aux réglementations de l'internet en république populaire de Chine, l'agent conversationnel de DeepSeek refuse d'aborder certains sujets politiquement sensibles en Chine (manifestations de la place Tian'anmen, statut de Taïwan, manifestations de 2019 à Hong Kong, accusations de travail forcé au Xinjiang) et redirige la conversation ou formule une réponse avant de l'effacer. L'agent conversationnel reconnaît occasionnellement que ses réponses s'alignent sur les positions officielles du gouvernement chinois[26],[28].

Plaintes et interdictions

Plaintes

En , Test-Achats, l'organisation de consommateurs belge, dépose plainte auprès de l'Autorité de protection des données contre DeepSeek. Lui est reproché un traitement des données en contravention avec le règlement général sur la protection des données (RGPD)[29].

En , Altroconsumo (it), une organisation de consommateurs italienne, dépose plainte auprès du Garant de la protection des données personnelles (it) contre DeepSeek[30]. L'association s'inquiète en effet d'un risque lié à la non conformité par DeepSeek au RGPD[31].

Interdictions

L'Italie interdit l'accès par DeepSeek aux données d'utilisateurs italiens.

L'Australie et Taïwan interdisent à leurs fonctionnaires et à des infrastructures clés d’utiliser DeepSeek[32].

Notes et références

- (en) Cet article est partiellement ou en totalité issu de l’article de Wikipédia en anglais intitulé « DeepSeek » (voir la liste des auteurs).

Notes

Références

- ↑ Ryan McMorrow et Eleanor Olcott, « The Chinese quant fund-turned-AI pioneer », Financial Times, (lire en ligne, consulté le ).

- ↑ (en) Lily Ottinger, « Deepseek: From Hedge Fund to Frontier Model Maker », sur chinatalk.media (consulté le ).

- ↑ (en-US) Julian Horsey, « Deepseek Coder open source AI coding assistant runs online and locally », sur Geeky Gadgets, (consulté le ).

- ↑ « Inside DeepSeek Models », sur Turing Post (consulté le ).

- ↑ (en) Deep-Seek AI, « DeepSeek-V2: A Strong, Economical, and Efficient Mixture-of-Experts Language Model ».

- ↑ « DeepSeek Coder V2, le nouveau modèle de référence pour le code », sur Le Journal du Net, (consulté le ).

- ↑ (en) « 🚀 Introducing DeepSeek-V3 », sur DeepSeek API Docs (consulté le ).

- ↑ « « Deepseek 3 », la réponse chinoise à Chat GPT relance la rivalité sino-américaine », sur France Inter, (consulté le ).

- ↑ (en-US) Timothy Prickett Morgan, « How Did DeepSeek Train Its AI Model On A Lot Less – And Crippled – Hardware? », sur The Next Platform, (consulté le )

- ↑ DeepSeek-AI, Aixin Liu, Bei Feng et Bing Xue, DeepSeek-V3 Technical Report, (DOI 10.48550/arXiv.2412.19437, lire en ligne)

- ↑ (zh-CN) « DeepSeek-R1 - DeepSeek推出的高性能AI推理模型,性能对标OpenAI o1正式版 », sur AI工具集, (consulté le ).

- ↑ (en) « DeepSeek-R1 Release », sur DeepSeek API Docs (consulté le ).

- ↑ « Intelligence artificielle : Deepseek V-3, la réponse chinoise à Chat-GPT ? », sur lepetitjournal.com (consulté le ).

- ↑ (en) Elizabeth Gibney, « China’s cheap, open AI model DeepSeek thrills scientists », Nature, (ISSN 1476-4687, DOI 10.1038/d41586-025-00229-6, lire en ligne

, consulté le )

, consulté le )

- ↑ « La start-up chinoise DeepSeek bouleverse le secteur de l’intelligence artificielle », Le Monde, (lire en ligne).

- ↑ « Why the markets are freaking out about Chinese AI newcomer DeepSeek » [« Pourquoi les marchés s'inquiètent-ils de l'arrivée de DeepSeek, un nouveau venu chinois dans le domaine de l'IA ? »], sur Ars Technica, (consulté le ).

- ↑ « Nvidia, AMD, Broadcom : l’IA chinoise DeepSeek fait plonger en bourse les géants de la Tech », sur Le Figaro, (consulté le ).

- ↑ Charles Delouche-Bertolasi et AFP, « Face à la percée de l’IA chinoise DeepSeek, la tech américaine et Wall Street dévissent », sur Libération (consulté le ).

- « DeepSeek : « cachez ces coûts que je ne saurais voir » », sur LeMagIT (consulté le )

- ↑ (en) Andy Chalk published, « Nvidia share price plummets as it loses more than $600B in valuation, the biggest single-day loss in history », PC Gamer, (lire en ligne, consulté le )

- ↑ (en) « Did DeepSeek copy ChatGPT to make new AI chatbot? Trump adviser thinks so », sur AP News, (consulté le )

- ↑ (en) Jess Weatherbed, « OpenAI has evidence that its models helped train China’s DeepSeek »

, sur The Verge, (consulté le )

, sur The Verge, (consulté le )

- ↑ Lucas Mediavilla, « Deepseek a-t-il pillé OpenAI ? L’Administration Trump remet en cause les prouesses de la start-up chinoise »

, sur Le Figaro, (consulté le )

, sur Le Figaro, (consulté le )

- ↑ (en) João da Silva et Graham Fraser, « OpenAI says Chinese rivals using its work for their AI apps »

, sur BBC, (consulté le )

, sur BBC, (consulté le )

- ↑ (en) Matt Burgess et Lily Hay Newman, « DeepSeek’s Popular AI App Is Explicitly Sending US Data to China »

, sur Wired, (consulté le )

, sur Wired, (consulté le )

- (en) Robert Booth et Dan Milmo, « Experts urge caution over use of Chinese AI DeepSeek », The Guardian, (ISSN 0261-3077, lire en ligne

, consulté le )

, consulté le )

- ↑ (en) Tom Gerken, « Be careful with DeepSeek, Australia says - so is it safe to use? »

, sur BBC, (consulté le )

, sur BBC, (consulté le )

- ↑ « "Parlons d'autre chose" : on a testé l'IA chinoise DeepSeek, qui n'échappe pas à la censure »

, sur France Info, (consulté le )

, sur France Info, (consulté le )

- ↑ « Données personnelles : Testachats dépose plainte contre DeepSeek »

, Le Soir, (consulté le ).

, Le Soir, (consulté le ).

- ↑ Miguel Allo, « DeepSeek, l’IA chinoise fait l’objet de deux plaintes déposées en Europe, dont l’une en Belgique »

, RTBF, (consulté le ).

, RTBF, (consulté le ).

- ↑ « Face à Deepseek, les États passent à l'offensive », sur Le Monde informatique, (consulté le ).

- ↑ « Pourquoi certains pays interdisent-ils DeepSeek ? », sur 20 Minutes, (consulté le )

Liens externes

- Sites officiels : (zh) www.deepseek.com et (en) www.deepseek.com/en

⭐ Évaluation collective ❔

| 🤖 Fonctionnalités | |

| 📱 Utilisabilité | |

| 🛡️Sécurité | |

| 💰 Prix | |

| 🎓 Alignement pédagogique | |

| 🐣 Maturité | |

|

Moyenne

|

|

|

|

![]()

🗨️ Vos retours libres

📢 On en parle sur l’ObsiaFormation

Simulation d’une méta-réflexion sur une analyse croisée : APC +

À travers un processus expérimental en quatre étapes — collecte, lecture, synthèse assistée par IA et extension — ce partage…

📰 Actualités récentes depuis la source

ℹ️ Plus d’infos via Wikipédia

NotebookLM

| Développé par | |

|---|---|

| Première version | [1] |

| Type | Logiciel de prise de notes (d) |

| Site web | notebooklm.google |

NotebookLM est une application web de recherche et de prise de notes développée par Google Labs. Elle utilise l'intelligence artificielle (IA), en particulier Google Gemini, pour aider les utilisateurs à interagir avec leurs documents. NotebookLM peut générer des résumés, des explications et des réponses en fonction du contenu téléchargé par les utilisateurs. Elle inclut également une fonctionnalité audio qui résume les documents dans un format conversationnel, similaire à un podcast[2],[3].

NotebookLM a été initialement lancé en 2023 sous le nom de « Project Tailwind »[3],[4]. Google le décrit comme un « assistant de recherche virtuel »[5]. Notebook signifie « carnet », et LM signifie Language Model (« Modèle de langage »)[6]. En plus des fichiers texte, NotebookLM peut traiter des fichiers PDF, des documents Google, et des sites Web[2]. La fonctionnalité audio, lancée en septembre 2024, a attiré l'attention des médias pour sa capacité à condenser des documents complexes en podcasts engageants[5],[7],[8]. Initialement destiné aux chercheurs, NotebookLM a également été adopté par les entreprises et les étudiants[2].

Références

- ↑ « https://blog.google/technology/ai/notebooklm-google-ai/ » (consulté le )

- (en) Emilia David, « Google’s NotebookLM evolves: What IT leaders need to know about its enterprise applications », sur VentureBeat, (consulté le )

- (en) David Pierce, « The chatbot becomes the teacher », sur The Verge, (consulté le )

- ↑ (en) James Vincent, « Google teases Project Tailwind — a prototype AI notebook that learns from your documents », sur The Verge, (consulté le )

- (en-US) Orland, « Fake AI “podcasters” are reviewing my book and it’s freaking me out », Ars Technica, (consulté le )

- ↑ (en) « Introducing NotebookLM », sur Google, (consulté le )

- ↑ (en-US) Malik, « Google's AI note-taking app NotebookLM can now explain complex topics to you out loud », TechCrunch, (consulté le )

- ↑ (en) Reporter, « Five productivity hacks using Google's new AI podcast creator », Newsweek, (consulté le )

⭐ Évaluation collective ❔

| 🤖 Fonctionnalités | |

| 📱 Utilisabilité | |

| 🛡️Sécurité | |

| 💰 Prix | |

| 🎓 Alignement pédagogique | |

| 🐣 Maturité | |

|

Moyenne

|

|

|

|

![]()

🗨️ Vos retours libres

📢 On en parle sur l’ObsiaFormation

Webinaire d’ouverture du cycle IA Sup-Intelligence artificielle et enseignement supérieur

La DGESIP a initié un cycle de webinaires lancé en septembre 2025 à destination de la gouvernance des établissements. Retour…

Panorama des Chartes sur l’utilisation de l’IA

Lorsque l’on parle des chartes, des déclarations, des recommandations, des préconisations mais aussi des interdictions et prises de positionnement, il…

Comparatif d’outils d’IA génératives

Ce petit comparatif a pour objectif de faire un très rapide état des lieux des principaux outils d’IA génératives à…

📰 Actualités récentes depuis la source

ℹ️ Plus d’infos via Wikipédia

Mistral AI

(en) Frontier AI. For all of us. L'IA de pointe. Pour tous. |

| Fondation |

|---|

| Type | |

|---|---|

| Forme juridique | |

| Domaines d'activité |

Intelligence artificielle, logiciel à source ouverte, services administratifs combinés de bureau, industrie du logiciel |

| Siège |

Paris, 15 rue des Halles 75001 |

| Pays |

| Effectif |

100 salariés[1] |

|---|---|

| Fondateurs |

Guillaume Lample (d), Timothée Lacroix (d), Arthur Mensch |

| Président | |

| Directeur scientifique |

Guillaume Lample[3] |

| Directeur technique |

Timothée Lacroix[3] |

| Directeur |

Arthur Mensch (depuis ) |

| Récompense | |

| Site web |

| SIREN | |

|---|---|

| TVA européenne | |

| OpenCorporates |

Mistral AI est une entreprise française fondée en avril 2023, spécialisée dans l'intelligence artificielle générative. Elle développe des grands modèles de langages de logiciel libre et propriétaires. Elle a été cofondée par Arthur Mensch, Guillaume Lample et Timothée Lacroix[2].

Durant sa première année d'existence, elle réalise trois levées de fonds successives, d'un montant total de plus d'un milliard d'euros. Sa dernière levée en septembre 2025 la valorise à plus de onze milliards d'euros[4]. Mistral est considérée comme l'un des leaders européens de l'intelligence artificielle[2].

L'entreprise est basée à Paris et dispose de bureaux au Royaume-Uni, ainsi que d'antennes à Palo Alto et à Singapour[1].

Historique

Lancement en 2023

Fondateurs

Avant de cofonder Mistral AI, Arthur Mensch travaillait chez DeepMind, le laboratoire d'intelligence artificielle de Google, tandis que Guillaume Lample, qui a fait partie des créateurs de LLaMA, et Timothée Lacroix étaient chercheurs chez Meta[2]'[5],[6].

Levée de fonds de juin 2023

En juin 2023, la jeune pousse réalise une première levée de fonds de 105 millions d'euros avec comme investisseurs le fond américain Lightspeed Venture Partners (en), Eric Schmidt, Xavier Niel et JCDecaux Holding notamment. La valorisation est alors estimée par le Financial Times à 240 millions d'euros[7].

Le , l'entreprise met à disposition son modèle de traitement du langage « Mistral 7B » sous licence libre Apache 2.0. Ce modèle comporte 7 milliards de paramètres, une taille restreinte par rapport à ses concurrents[8].

Levée de fonds de décembre 2023

Le , Mistral AI annonce avoir levé 385 millions d'euros dans le cadre de sa seconde levée de fonds[2] et devient l'une des licornes françaises, valorisée à 2 milliards de dollars[9]. Ce tour de table implique notamment le fonds californien Andreessen Horowitz, la BNP Paribas et l'éditeur de logiciels Salesforce[10],[11].

Le , l'entreprise sort le modèle « Mixtral 8x7B » comptant 46,7 milliards de paramètres mais n'en utilisant que 12,9 milliards par jeton textuel grâce à l'architecture du mélange d'experts (en). Le modèle maîtrise 5 langues (français, espagnol, italien, anglais et allemand) et surpasse, d'après les tests de ses développeurs, le modèle « LLama 2 70B » de Meta.

Le même jour, Mistral annonce la version bêta de sa plateforme de services permettant aux développeurs de solliciter directement ses modèles[12].

Consolidation et nouvelle levée de fonds en 2024

En , Cédric O, actionnaire et conseiller en affaires publiques de Mistral AI, recrute Audrey Herblin-Stoop pour s'occuper des affaires publiques[13].

Lancement de la plateforme Le Chat le 26 février 2024

Le , Mistral lance « Le Chat », un robot conversationnel similaire à ChatGPT permettant d'essayer les modèles de l'entreprise[14],[15]. Dans la foulée, elle dévoile Mistral Large, un nouveau modèle de langage capable de rivaliser avec GPT-4[16], une version allégée appelée Mistral Small, et Mistral Next, un prototype conçu pour donner des réponses brèves et concises[17].

Partenariat avec Microsoft

Le même jour, Mistral annonce un partenariat avec Microsoft[18] afin de rendre disponible leur modèle Mistral Large sur le cloud Azure. Au terme de cet accord, l'entreprise américaine devrait prendre une participation minoritaire au capital de l'entreprise[19]. Le partenariat doit permettre à Mistral AI de distribuer ses modèles aux entreprises, en échange d'un partage des revenus avec Microsoft[20]. Le partenariat inclut également une recherche et développement en vue de créer des applications pour tous les gouvernements européens et répondre aux besoins spécifiques du secteur public en IA[21].

Le mercredi 10 avril, la société publie sur Twitter le modèle « Mixtral 8x22b », téléchargeable depuis un lien magnet sous licence libre Apache 2.0. Il repose sur le principe du mélange d'experts, comme son prédécesseur Mistral 8x7b[22]. Il compte 176 milliards de paramètres et possède une fenêtre de contexte de 65 000 jetons[23].

Lancement du modèle de langage Codestral

Fin mai, l'entreprise lance un modèle de langage appelé « Codestral » dédié à la génération de code informatique. Comptant 22 milliards de paramètres, il est distribué sous une nouvelle licence dite « Mistral AI non-production license ». Celle-ci restreint l'utilisation du modèle à des fins de recherche scientifique et de test et exclut donc les usages commerciaux[24].

Levée de fonds de juin 2024

En juin 2024, Mistral lève 600 millions d'euros à l'issue d'un tour de financement mené par le fonds américain General Catalyst (en). 65 % du capital reste français d'après le fondateur Arthur Mensch[25].

En juillet, l'entreprise dévoile deux nouveaux modèles open source : Codestral Mamba 7B et Mathstral 7B, ainsi que Mistral NeMo 12B, un modèle développé avec NVIDIA (via la plateforme NVIDIA DGX Cloud et le framework NVIDIA NeMo), un modèle aux performances élevées, dopé par l'utilisation du format de données FP8, particulièrement efficace en anglais, français, allemand, espagnol, italien, portugais, chinois, japonais, coréen, arabe et hindi, basé sur un nouvel analyseur lexical dit « Tekken ». Celui-ci est basé sur Tiktoken et entraîné sur plus de cent langues. Il surpasse l' analyseur SentencePiece des précédents modèles Mistral pour compresser le langage naturel et le code source : il est environ 30 % plus efficace pour compresser le code source et plusieurs langues majeures et jusqu'à trois fois plus efficace pour le coréen et l'arabe. Les poids du modèle, qui est empaqueté dans un conteneur NVIDIA NIM, sont disponibles sur Hugging Face et la plateforme de Mistral AI. Il peut remplacer les systèmes utilisant Mistral 7B, par exemple pour les agents conversationnels, les tâches multilingues, le codage et la synthèse de document. Selon les tests de Mistral AI, il dépasse Gemma 2 9B et Llama 3 8B, deux modèles de logiciel libre sortis quelques mois avant[26].

En octobre, Mistral publie deux petits modèles dits « Ministraux », Mistral 3B et Mistral 8B. Leur faible nombre de paramètres, respectivement 3 et 8 milliards, en fait des modèles légers qui nécessitent moins de capacité de calcul que la plupart des autres modèles de langage. Cela leur permet d'être embarqués dans des systèmes informatiques autonomes isolés d'internet[27].

Nouvelles fonctionnalités en novembre 2024

Le 19 novembre 2024, l'entreprise ajoute plusieurs fonctionnalités majeures à son robot conversationnel Le Chat. Celui-ci devient capable de générer des images, grâce à un partenariat avec Black Forest Labs et leurs modèles Flux Pro. De plus, Mistral ajoute la possibilité de chercher des informations sur internet afin d'avoir des informations fiables et à jour. Enfin, elle introduit le système de Canvas, une interface collaborative dans laquelle l'IA crée du code et l'utilisateur peut le modifier.

Simultanément, l'entreprise introduit un nouveau modèle, Pixtral Large, une amélioration de Pixtral 12B, intégrant un encodeur visuel d'1 milliard de paramètres couplé à Mistral Large 2. Enfin, celui-ci a également été amélioré, notamment pour les longs contextes et les appels de fonctions[28].

Depuis 2025

Le 13 janvier 2025, Mistral sort une version améliorée de Codestral, disposant d'un meilleur analyseur et d'une architecture plus efficace, ce qui lui permet de compléter le code informatique deux fois plus rapidement[29].

Accord avec l'Agence France-Presse

Trois jours plus tard, l’AFP et Mistral officialisent un accord qui permet au Chat d'utiliser toutes les dépêches de l’AFP publiées depuis 1983, soit 38 millions de dépêches à la signature de ce contrat. Il est spécifié qu’elles ne serviront pas à de l’entraînement mais seulement à répondre aux requêtes des utilisateurs[30]. Le 30 janvier, elle sort Mistral small 3, une amélioration du modèle, en ajoutant 2B de paramètre, passant de 22B à 24B[31].

Début mars 2025, Mistral annonce la mise à disposition d'une API OCR qui permet de traiter des documents PDF complexes[32].

Partenariat avec CMA CGM

En avril 2025, Mistral AI annonce un partenariat de cent millions d'euros avec la compagnie maritime CMA CGM qui souhaite investir dans l'intelligence artificielle afin de gagner en efficacité dans l’ensemble de ses métiers, du transport à la logistique en passant par les médias[33].

Nouvelle levée de fonds et partenariat avec ASML

Le 9 septembre 2025, Mistral annonce une nouvelle levée de fonds de 1,7 milliard d'euros ainsi que l'entrée à son capital d'ASML, ce dernier devenant son principal actionnaire avec une prise de participation de 11%. Cette levée de fonds porte ainsi la valorisation de Mistral AI à 11,7 milliards d'euros, ce qui en fait la société d'IA la plus valorisée d'Europe. Cette annonce marque également le lancement d'un partenariat stratégique avec ASML pour que le géant néerlandais des machines à graver les semi-conducteurs utilise ses modèles d'intelligence artificielle dans l'ensemble de son portefeuille de produits[34][4].

Modèles

Mistral met à disposition plusieurs modèles d'I.A. générative sur sa plateforme Le Chat (Mistral Large, Mistral Small, Mistral Next[35]) et met aussi à disposition d'autres modèles via son API.

| Nom du modèle | Description |

| Mistral 7B | Un modèle de langage de grande taille avec 7 milliards de paramètres, optimisé pour une variété de tâches de traitement du langage naturel. |

| Mistral Tiny | Un modèle plus petit et plus léger, conçu pour des applications nécessitant une faible latence et une faible consommation de ressources. |

| Mistral Embed | Un modèle spécialisé dans la génération d'embeddings, utile pour des tâches comme la recherche sémantique et la classification. |

| Mistral Saba | Un modèle de 24B paramètres formé sur des ensembles de données soigneusement sélectionnés à travers le Moyen-Orient et l'Asie du Sud, conçu pour fournir un contexte linguistique et culturel régional. |

| Mixtral 8x7B | Un modèle de mélange de spécialistes (SMoE) avec des poids ouverts, performant et efficace en termes de coût et de latence. |

| Magistral Small | Un modèle open-weight spécialisé dans le raisonnement, disponible pour l'auto-déploiement sous la licence Apache 2.0. |

| Devstral Small | Un modèle optimisé pour les tâches de codage et les capacités agentiques, disponible via l'API de Mistral AI. |

| Devstral Medium | Un modèle plus puissant pour les tâches de codage et les capacités agentiques, disponible pour les clients entreprises et via l'API de fine-tuning de Mistral AI. |

| Mistral Medium 3 | Un modèle offrant des performances de pointe à un coût significativement inférieur, adapté aux contextes d'entreprise. |

| Ministral 3B / 8B | Des modèles d'entreprise avec 3 milliards et 8 milliards de paramètres respectivement, conçus pour des performances élevées et des coûts réduits. |

| Mistral OCR | Un modèle spécialisé dans la reconnaissance optique de caractères (OCR), utile pour extraire du texte à partir d'images et de documents. |

| Mistral Large | Un modèle puissant pour des tâches complexes nécessitant de grandes capacités de raisonnement ou des spécialisations élevées. |

| Pixtral | Un modèle mentionné parmi les modèles ouverts de Mistral AI, bien que les détails spécifiques ne soient pas fournis dans les résultats de recherche. |

Modèle économique

Mistral AI se démarque par sa stratégie de logiciel libre et son modèle économique plus léger, en misant sur l'efficacité et l'optimisation des ressources[36]. Son modèle Mixtral 8x22B recourt à une architecture de Mixture of Experts (MoE), conçue pour que seulement une partie des paramètres soit activée, en fonction de la tâche demandée.

Notes et références

- « La question du jour. Utiliseriez-vous une Intelligence artificielle française au lieu de ChatGPT ? | Courrier de l'Ouest », Courrier de l'Ouest, (lire en ligne, consulté le )

- « La start-up française Mistral AI a levé 385 millions d'euros », Le Monde.fr, (lire en ligne, consulté le ).

- « Mistral AI, pépite de l’IA, cofondée par deux X, a levé près de €500 mlns en 2023 - École polytechnique, école d'ingénieur », sur www.polytechnique.edu (consulté le ).

- Lucas Mediavilla, « En investissant 1,3 milliard d’euros, le géant néerlandais ASML devient le premier actionnaire de Mistral AI », sur Le Figaro, (consulté le )

- ↑ Élisabeth Montaufray-Bureau, « Comment le français Mistral AI rêve de devenir un géant de l’intelligence artificielle », sur Ouest France, lemans.maville.com, (consulté le ).

- ↑ Thomas Lestavel, « IA générative : l'Europe a les talents, pas les moyens », sur Alternatives Economiques, (consulté le ).

- ↑ Usine Digitale, « La start-up française Mistral AI lève 105 millions d'euros pour développer des modèles d'IA générative », L'Usine Digitale, (lire en ligne, consulté le ).

- ↑ « Le modèle de Mistral AI concurrence celui de CHAT-GPT », sur infonet.fr (consulté le )

- ↑ Metz C (2023). Mistral, French AI Start-Up, Is Valued at $2 Billion in Funding Round. The New York Times (Digital Edition), NA-NA.|url=https://go.gale.com/ps/i.do?id=GALE%7CA777029768&sid=googleScholar&v=2.1&it=r&linkaccess=abs&issn=15538095&p=AONE&sw=w

- ↑ Célia Seramour, « Mistral lève 385 M€ et devient une licorne française », sur Le Monde Informatique, (consulté le ).

- ↑ Article par Leïla Marchand le 4 décembre 2023 dans Les Echos [1]

- ↑ « Mistral AI lève 385 millions d'euros et lance ses premiers produits », sur LeMagIT (consulté le ).

- ↑ Charlie Perreau, « Audrey Herblin-Stoop, le nouveau visage de Mistral AI », Les Echos, (lire en ligne).

- ↑ « En quoi "le chat", IA conversationnelle développée par des Français, est-il meilleur que ChatGPT », sur laprovence.com, (consulté le ).

- ↑ Nicolas Six, « On a testé Le Chat, l'étonnant ChatGPT à la française de Mistral AI », Le monde, (lire en ligne

, consulté le ).

, consulté le ).

- ↑ « Avec Le Chat et Mistral Large, le français Mistral impressionne (encore) », sur journaldunet.com, (consulté le ).

- ↑ (en-US) Romain Dillet, « Mistral AI releases new model to rival GPT-4 and its own chat assistant », sur TechCrunch, (consulté le ).

- ↑ « La start-up française Mistral AI annonce un partenariat avec Microsoft », sur L'Usine Nouvelle, (consulté le ).

- ↑ Reuters, « La start-up française Mistral AI annonce un partenariat avec Microsoft », sur Challenges, (consulté le ).

- ↑ Alexandre Piquard, « Arthur Mensch, de Mistral AI : « En intelligence artificielle, nous pouvons rivaliser avec Google ou OpenAI » », Le Monde, (lire en ligne, consulté le ).

- ↑ Madhumita Murgia, « Microsoft strikes deal with Mistral in push beyond OpenAI », sur Financial Times, (consulté le ).

- ↑ Julien Lausson, « La startup française Mistral AI sort en torrent un autre modèle de langage, de 262 Go », sur Numerama, (consulté le ).

- ↑ (en) « AI startup Mistral launches a 281GB AI model to rival OpenAI, Meta, and Google », sur ZDNet (consulté le ).

- ↑ Usine Digitale, « Mistral AI dévoile Codestral, un LLM adapté aux tâches de génération de code », L'Usine digitale, (lire en ligne, consulté le ).

- ↑ « La nouvelle méga levée de Mistral AI », sur Capital Finance, (consulté le ).

- ↑ « Collaboration de pointe : Mistral AI et NVIDIA lancent Mistral NeMO 12 B », ActuIA, (lire en ligne, consulté le ).

- ↑ « Avec Ministral 3B et 8B, Mistral AI accélère sur les SLM - Le Monde Informatique », sur LeMondeInformatique, (consulté le )

- ↑ Matthieu Eugène, « Le Chat : Mistral lance des nouveautés majeures pour son IA concurrente de ChatGPT », sur BDM, (consulté le ).

- ↑ « Mistral double la vitesse Codestral », sur ITdaily., (consulté le )

- ↑ « Intelligence artificielle : l’Agence France-Presse et l’entreprise française Mistral AI signent un accord », Le Monde, (lire en ligne, consulté le )

- ↑ Usine Digitale, « Mistral AI fait les yeux doux à la communauté open source avec son dernier modèle Small 3 », www.usine-digitale.fr, (lire en ligne, consulté le )

- ↑ « Pourquoi Mistral AI propose un nouvel OCR », sur ZD NET, (consulté le )

- ↑ « CMA CGM et Mistral AI nouent un partenariat de 100 millions d’euros dans l’intelligence artificielle », sur Le Figaro, (consulté le )

- ↑ « Mistral AI lève €1,7 md, ASML devient son principal actionnaire », sur Boursorama, (consulté le )

- ↑ « Le Chat | Mistral AI », sur mistral.ai (consulté le )

- ↑ Article de Tiernan Ray, le 20 mars 2025 sur ZDNet [2]

Voir aussi

Articles connexes

- Interactions humain-machine / IHM

- Anthropic, ChatGPT, GPT-3, GPT-4

- Intelligence artificielle / IA / AI

- Intelligence artificielle générative / IAg / GenAI

- Agent conversationnel / chatbot

- Interface en ligne de commande / command line interface / LCI / CLI

- Apprentissage par renforcement

- Analyse lexicale

- JSON Web Token

Liens externes

- Site officiel

- Ressources relatives aux organisations :

Bibliographie

- McDonald, D., Papadopoulos, R., & Benningfield, L. (2024). Reducing llm hallucination using knowledge distillation: A case study with mistral large and mmlu benchmark. Authorea Preprints. https://www.techrxiv.org/doi/full/10.36227/techrxiv.171665607.76504195

⭐ Évaluation collective ❔

| 🤖 Fonctionnalités | |

| 📱 Utilisabilité | |

| 🛡️Sécurité | |

| 💰 Prix | |

| 🎓 Alignement pédagogique | |

| 🐣 Maturité | |

|

Moyenne

|

|

|

|

![]()

🗨️ Vos retours libres

📢 On en parle sur l’ObsiaFormation

Comparatif d’outils d’IA génératives

Ce petit comparatif a pour objectif de faire un très rapide état des lieux des principaux outils d’IA génératives à…

📰 Actualités récentes depuis la source

🗓️ 2 octobre 2025 ⌚ 16h00

Get the scoop on how to use Nano Banana, the Gemini app’s viral new image generation and editing model from Google DeepMind.

🗓️ 1 octobre 2025 ⌚ 17h18

Learn more about the new Google Home Premium subscription plan, including pricing, what’s included and more.

🗓️ 1 octobre 2025 ⌚ 13h00

Learn more about Gemini for Home, new Home hardware and the totally redesigned Google Home app.

🗓️ 1 octobre 2025 ⌚ 13h00

Learn more about the newly redesigned Google Home app, built for Gemini.

🗓️ 1 octobre 2025 ⌚ 13h00

Learn more about Gemini for Home, powering new, smarter AI features for Google Nest and other smart home products.

🗓️ 1 octobre 2025 ⌚ 12h00

The Global AI Film Award is now accepting applications from creators using Google AI tools, with the winner awarded a prize of USD 1 million by the 1 Billion Followers S…

🗓️ 24 septembre 2025 ⌚ 16h00

Google AI Pro and Ultra subscribers now get higher limits to Gemini CLI and Gemini Code Assist IDE extensions.

🗓️ 23 septembre 2025 ⌚ 19h00

Google AI Plus — our newest AI plan — is now available in more than 40 more countries.

🗓️ 23 septembre 2025 ⌚ 16h00

Earlier this year, we launched the second iteration of our GenAI Intensive course, which attracted over 280,000 learners. Now, we’re taking things to the next level with…

🗓️ 23 septembre 2025 ⌚ 14h23

Guided Learning with Gemini is a new feature from Google that offers people a personalized, interactive and effective way to learn.

🗓️ 19 septembre 2025 ⌚ 16h00

Gemini Drops is our new monthly update on how to get the most out of the Gemini app.

🗓️ 19 septembre 2025 ⌚ 16h00

Here’s how I’ve been using Gemini’s photo-to-video tool as a multimedia storyteller, plus some tips for making your own videos.

🗓️ 18 septembre 2025 ⌚ 16h00

You can now share your custom Gems in the Gemini app.

🗓️ 17 septembre 2025 ⌚ 17h30

Gemini achieves gold status at the ICPC, marking a new leap in AI’s abstract problem-solving.

🗓️ 17 septembre 2025 ⌚ 14h30

Google’s deep investments in American technical infrastructure, R&D and the workforce will help the U.S. continue to lead the world in AI.

ℹ️ Plus d’infos via Wikipédia

Gemini (IA)

Generalized Multimodal Intelligence Network

| Créateur | |

|---|---|

| Développé par | Google DeepMind |

| Première version | Bard Expérimental () |

| Dernière version | Gemini 2.5 Flash/Pro (25 mars 2025 - 17 avril 2025) |

| État du projet | Actif |

| Système d'exploitation |

Windows, macOS, Linux (Web) Android (Application) iOS (Application) |

| Environnement | Navigateur web, Android et iOS |

| Langues | 46 langues |

| Type |

Dialogueur Prototype Grand modèle de langage IA conversationnelle (d) Application web Chatbot d'intelligence artificielle générative (d) |

| Site web | https://gemini.google.com |

Gemini, anciennement Bard, est un assistant conversationnel développé par Google. Pour générer du texte, il se base sur une famille de grands modèles de langage également appelée Gemini, introduite au public le [1]. Gemini est l'acronyme de Generalized Multimodal Intelligence Network. Les modèles se déclinent en trois tailles: nano, pro et ultra[2].

Gemini peut comprendre et interagir avec l'audio et la vidéo, et générer du texte (poésie, scripts, pièces musicales, courriels, lettres, etc.), du code, des traductions (entre plus de 100 langues). Il peut produire plusieurs types de contenu créatif (images, dessins, sons, musique, vidéos…), aider des chercheurs en analysant des données ou en générant des hypothèses. Gemini peut répondre aux questions de manière informative ou en produisant des cours personnalisés, des jeux, des tutoriels, etc., avec les limites des IA (erreurs, biais, « hallucinations »…).

Il est disponible via une application moblile et est directement intégré sur plusieurs appareils dont les écrans (smartphones, tablettes, montres pixel watch, etc...) Google pixel ainsi que les produits de la gamme Nest de Google.[3]

Description

Gemini désigne une famille de transformeurs génératifs préentraînés permettant notamment de générer du texte. Le terme désigne également l'assistant conversationnel qui utilise ces modèles.

Multimodalité

Gemini a été annoncé en 2023 comme devant surpasser les modèles existants comme GPT-4, en pouvant traiter simultanément et de manière polyvalente divers types différents de données (texte, images, sons et vidéos). Il peut ainsi répondre à une large variété de demandes, comme la génération de textes écrits, d'images, de sons et de code ; l'analyse de flux vidéo, la création de modèles 3D complexes, l'analyse et l'interprétation de graphiques complexes, de cartes, etc.[4],[5]. L'architecture de Gemini comporte un encodeur et un décodeur. L'encodeur de Gemini convertit certains types de données en vecteurs, que le décodeur peut comprendre et utiliser pour la génération[6].

Variantes

Selon Google, Gemini est particulièrement douée pour le codage informatique, grâce à son nouveau système de génération de code AlphaCode 2 basé sur Gemini Pro, qui lui permettrait de surpasser 85 % des concurrents[7]. Google DeepMind a également conçu Gemini Robotics, un modèle vision-langage-action permettant de contrôler des robots[8].

Histoire

Contexte

Au début des années 2020, dans le domaine de l'IA générative, Google a été distancé par ChatGPT. Tout en poursuivant ses projets d'IA (ex. : Teachable Machine, Quick Draw, AutoDraw, Art Palette, ou Semantris et BARD) Google a mis en avant son nouveau projet majeur : Gemini AI, qui est une collaboration entre Google Brain (connue pour avoir créé l'outil Google Traduction, ainsi que TensorFlow, les modèles Transformer (le T de GPT) et le modèle LaMDA, qui permet à Bard de fonctionner) et DeepMind (filiale de Google, notamment connue pour avoir créé AlphaGo, le système d'IA qui a battu Lee Sedol au jeu de go en 2016, et AlphaFold capable de prédire la structure des protéines). Ces deux groupes ont fusionné en 2023 pour accélérer la mise au point de Gemini après le succès de ChatGPT.

En novembre 2022, OpenAI a lancé ChatGPT, un assistant conversationnel (chatbot) initialement basé sur GPT-3.5. ChatGPT a attiré l'attention du monde entier après sa sortie, devenant une sensation virale sur Internet. Alarmé par la menace potentielle de ChatGPT pour la recherche Google, le PDG de Google, Sundar Pichai, a émis une alerte « code rouge » à l'échelle de l'entreprise, réaffectant plusieurs équipes pour venir renforcer les efforts de l'entreprise en matière d'IA[9]. Dans un geste rare et sans précédent, les cofondateurs de Google Larry Page et Sergey Brin, qui avaient quitté leurs fonctions de co-PDG de la société mère de Google Alphabet en 2019, ont été convoqués à des réunions d'urgence avec des dirigeants de l'entreprise pour discuter de la réponse de Google à ChatGPT.

Interrogés par les employés lors d'une réunion générale pour savoir si le grand modèle de langage LaMDA était une occasion manquée pour Google de concurrencer ChatGPT, Sundar Pichai et Jeff Dean (le dirigeant de Google AI) ont déclaré que Google avait des capacités similaires, mais aller trop vite dans ce domaine représenterait un « risque réputationnel » majeur en raison du fait que Google est nettement plus grand qu'OpenAI[10],[11]. En janvier 2023, le PDG de DeepMind, Demis Hassabis, a annoncé les plans d'un rival de ChatGPT, et les employés de Google ont été chargés d'accélérer les progrès sur un concurrent de ChatGPT, en testant intensivement « Apprentice Bard » et d'autres chatbots[12],[13]. Sundar Pichai a assuré lors de l'appel aux investisseurs pendant la présentation des résultats trimestriels de Google en février que la société avait l'intention d'étendre la disponibilité et les applications de LaMDA[14].

Peu de données étaient disponibles sur Gemini avant décembre 2023, mais selon Google, ce nouveau système d'IA pourrait remplacer et améliorer PaLM 2 de Google, dont en intégrant des techniques plus efficaces d'apprentissage par renforcement, permettant une amélioration continue des capacités des systèmes d'IA à répondre à des questions complexes.

Dès le début d'année 2023, Google avait annoncé une riposte claire à OpenAI au travers du projet Sparrow un chatbot qui avait l'avantage, contrairement à ChatGPT, de citer ses sources[15], gagnant ainsi en crédibilité.

Gemini a été entrainé sur les Tensor Processing Units (TPU) de Google[réf. nécessaire]. Plus rapide et moins couteux dans ses exécutions que les précédents modèles de Google (comme PaLM), Gemini intègre en particulier des « mécanismes d'attention » (MA) perfectionnés, permettant aux réseaux de neurones artificiels de « concentrer » leurs calculs sur les parties les plus pertinentes des « données d'entrée », pour générer ensuite des « sorties » plus cohérentes, et répondant plus fidèlement aux « invites » des utilisateurs.

La capacité annoncée de Gemini à générer et combiner des objets sonores, visuels (graphiques et cartographie y compris) et du texte devrait également lui permettre de générer plus d'un type de données à la fois. Gemini pourra probablement, par exemple, extraire des caractéristiques d'une vidéo, d'un podcast ou d'un texte complexe pour en générer une analyse ou un résumé en tenant compte plus finement des demandes de l'utilisateur, mais aussi — et éventuellement dans le même temps — créer du contenu nouveau et le mettre en page, l'illustrer d'images, de graphiques et/ou de cartographies, en créer une version vidéo ou podcast, multilingue, etc.

Bard et Gemini Pro

Le 2023, Google a annoncé Bard, un chatbot utilisant LaMDA pour générer du texte[16]. Bard a d'abord été déployé auprès d'un groupe restreint de « testeurs de confiance[17] », avant une large diffusion prévue à la fin du mois[18],[19]. Il a été développé sous le nom de code « Atlas »[20]. Dans la foulée de l'annonce de Google, le rival de Google, Microsoft, a révélé son partenariat avec OpenAI pour intégrer ChatGPT dans son moteur de recherche Bing, après avoir précédemment investi 10 milliards $ dans OpenAI[21],[22].

Bard a été présenté dans une vidéo promotionnelle sur Twitter le . Lors de cette vidéo, Bard s'est trompé en répondant à une question sur le télescope James Webb, provoquant l'inquiétude quant à la fiabilité du chatbot et dans la foulée la chute de l'action Google (Alphabet) de plus de 7 %[23]. Google Bard a été interrogé sur les nouvelles découvertes du télescope spatial James Webb et a répondu avec trois puces, y compris une déclaration selon laquelle le télescope « a pris les toutes premières images d'une planète en dehors de notre propre système solaire ». Cependant, cette affirmation était incorrecte[24].

Mi-2023, Gemini est encore en phase d'entraînement, et testé pour sa sécurité. Comme c'était déjà le cas pour PaLM 2, Google propose plusieurs itérations du modèle, de tailles différentes, qui seront exploitées en fonction des avancées de l'IA, des besoins émis en interne par les services ou filiales de Google, puis par les utilisateurs et clients, et en fonction de contraintes spécifiques[25]. Les versions de Gemini, en différentes tailles et capacités[26], pourraient être disponibles via le « Google Cloud Vertex AI » (anciennement « Google AI Platform »), une « plateforme d'apprentissage automatique, qui regroupe tous les services cloud de Google, permet de faciliter le déploiement et la maintenance des modèles d'IA »[25]. Une version préliminaire de Gemini a été fournie à un petit groupe externe de développeurs et d'entreprises afin d'effectuer des tests[27].

Depuis le [28], Bard utilise un modèle d'intelligence artificielle appelé Gemini Pro lorsqu'il communique en anglais. Ce modèle peut traiter et fusionner différents types d'informations tels que le texte, les images, l'audio et le code. Gemini Pro est actuellement disponible uniquement pour l'anglais sur Bard, mais son expansion à d'autres langues et régions, notamment en Europe, est prévue prochainement. Gemini Pro se concentre actuellement sur le traitement de textes, mais devrait bientôt être capable de travailler avec d'autres types de contenus[29]. De plus une suite qui compte trois modèles est annoncée :

- Gemini Nano : version allégée de Gemini est prévue pour tourner nativement et hors-ligne sur des smartphones Android en commençant par le Google Pixel 8 Pro et uniquement à partir de texte ;

- Gemini Pro : le modèle intermédiaire, remplacera LaMDA dans Bard pour les pays anglophones ;

- Gemini Ultra (qui ne sera finalement lancé qu'en ) : le modèle le plus avancé, et le plus performant.

Si Google DeepMind ne précise pas les tailles des modèles, l'accent est mis sur les performances du plus puissant (Gemini Ultra) par rapport à GPT-4[30] d'OpenAI, qui est alors de loin le modèle le plus puissant du marché.

Il est annoncé aussi que Gemini Pro sera disponible pour les développeurs via le Google Generative AI Studio ou Vertex AI sur Google Cloud le et que Gemini Ultra sera proposée aux Data Centers et aux entreprises, d'abord en version beta contrôlée et dans un contexte expérimental sécurisée.

Gemini

Le , Google a annoncé renommer Bard en Gemini afin de refléter l'utilisation de la famille de modèles Gemini[31].

Le , Google lance une nouvelle version plus avancée nommée Gemini 1.5 Pro. C'est aussi le premier modèle capable de prendre jusqu'à 1 million de tokens en entrée, même si la limite est fixée à 128 000 tokens dans un premier temps.

Le même mois, Google suspend son outil de création d'images Gemini, « pensé pour promouvoir la diversité », après qu'il a généré des résultats embarrassants, refusant dans certains cas de représenter des personnes blanches ou générant des images historiquement fausses, telles que « des soldats nazis de couleur » ou le « pape imaginé en femme ». Des polémiques en série, dont l'une liée à l'affirmation de Gemini selon laquelle il serait « difficile de dire » qui de Hitler ou d’Elon Musk avait eu l’impact le plus négatif sur la société, poussent Sundar Pichai, le PDG de Google, à recadrer ses équipes. Il leur rappelle le risque de briser la confiance envers les produits Google. Il déplore les réponses embarrassantes de Gemini qui « ont fait preuve de partialité »[32],[33]

En mai, une version allégée est lancée, nommée Gemini 1.5 Flash et capable d'accepter 1 million de tokens. Gemini 1.5 Pro bénéficie d'une amélioration à ce niveau, permettant d'utiliser jusqu'à 2 millions de tokens en entrée.

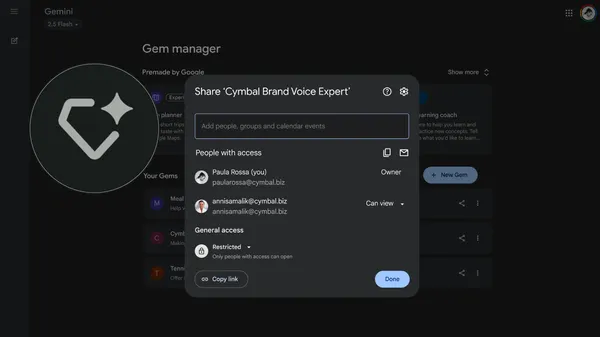

En , Google introduit les « Gems », qui permettent de créer des versions personnalisées de Gemini que les utilisateurs définissent en fonction de leurs besoins[34]. C'est une réponse au GPT Store de OpenAI ou au Copilot Studio de Microsoft, et l'un des nombreux efforts que déploie le groupe pour tenter d'attirer du public vers Gemini, alors que l'adoption des professionnels et développeurs restent très faible par rapport aux rivaux[35].

En mars 2025 Google annonce la sortie du modèle Gemini 2.5 (disponible en 3 versions : Pro, Flash et Flash-Lite), dont la déclinaison la plus puissante se retrouve directement en haut du classement de LMArena. Bénéficiant d'une fenêtre d'un million de token en entrée, le modèle domine encore actuellement les benchmarks scientifiques et mathématiques AIME et GPQA [36].

Références

- (en) Cet article est partiellement ou en totalité issu de l’article de Wikipédia en anglais intitulé « LaMDA#Bard » (voir la liste des auteurs).

- ↑ « Google renomme son assistant Bard en Gemini », sur Le Monde Informatique, (consulté le )

- ↑ Hugo Bernard, « Gemini : tout savoir sur l'IA de Google qui veut remplacer ChatGPT », sur Frandroid, (consulté le )

- ↑ Ulrich ROZIER, « Comment Gemini va remplacer Google Assistant sur les enceintes Home et Nest », Frandroid, 21/08/2025 • 15:37 (lire en ligne)

- ↑ Yohann Poiron, « Qu’est-ce que Google Gemini : la nouvelle génération d’IA ? », sur blog-nouvelles-technologies.fr, .

- ↑ Eray Eliaçık, « Qu’est-ce que l’IA Gemini de Google qui quintuple GPT-4 ? », sur dataconomy.com, .

- ↑ (en) Sahil Kapoor, « What Is Google's AI Project Gemini and What Is It Working On? », sur makeuseof.com, (consulté le ).

- ↑ « AlphaCode 2, la dernière IA de programmation compétitive de DeepMind », sur ActuIA, (consulté le )

- ↑ « Google sort un modèle Gemini capable de tourner en local sur des robots », sur L'Usine Digitale,

- ↑ « "Code rouge" chez Google : la popularité de ChatGPT inquiète la direction », sur www.lesnumeriques.com (consulté le )

- ↑ (en) Jennifer Elias, « Google execs warn company's reputation could suffer if it moves too fast on AI-chat technology » [archive du ], CNBC, (consulté le )

- ↑ Vincent, « Google won't launch ChatGPT rival because of 'reputational risk' » [archive du ], The Verge, (consulté le )

- ↑ (en) Jennifer Elias, « Google is asking employees to test potential ChatGPT competitors, including a chatbot called 'Apprentice Bard' » [archive du ], CNBC, (consulté le )

- ↑ Zacharie Tazrout, « Google veut rivaliser avec ChatGPT grâce à Apprentice Bard », sur Siècle Digital, (consulté le )

- ↑ (en) Aisha Mailk, « Google tries to reassure investors on AI progress as ChatGPT breathes down its neck » [archive du ], TechCrunch, (consulté le )

- ↑ Alexis Lood, « Choqué par ChatGPT, l’empire Google lance une contre-attaque », sur Android MT, (consulté le )

- ↑ Maurine Briantais, « Bard, l'IA révolutionnaire de Google : ça va barder pour ChatGPT ! », sur www.commentcamarche.net, (consulté le )

- ↑ (en) Sundar Pichai, « An important next step on our AI journey », sur Google, (consulté le )

- ↑ « IA : Google officialise Bard pour répondre à ChatGPT », sur Génération NT (consulté le )

- ↑ « Google officialise son agent conversationnel Bard, le rival de ChatGPT », sur MSN (consulté le )

- ↑ (en) Michael Liedtke, « Google hopes 'Bard' will outsmart ChatGPT, Microsoft in AI » [archive du ], Associated Press, (consulté le )

- ↑ Kevin Roose, « Intelligence artificielle: Comment ChatGPT a provoqué une « course à l’armement » », La Presse, (lire en ligne, consulté le )

- ↑ Pierre FONTAINE, « Microsoft va intégrer GPT-4 à Bing, et OpenAI prépare une appli mobile de ChatGPT », sur 01net.com, (consulté le )

- ↑ « Le chatbot de Google Bard commet une bourde à plusieurs milliards de $ », sur Astuto, (consulté le )

- ↑ (en) Tom, « Google Bard AI gets fact-checked: The story behind the $100 billion mistake »

, sur skymagzines, (consulté le )

, sur skymagzines, (consulté le )

- Florian Bayard, « Gemini : le « ChatGPT 4 » de Google arrive à grands pas », sur 01net.com, (consulté le ).

- ↑ (en) Adam Speight, « What is Google Gemini? The next-generation AI model explained », sur Trusted Reviews, (consulté le ).

- ↑ (en) « Google Nears Release of Gemini AI to Challenge OpenAI », sur The Information (consulté le )

- ↑ Marc Zaffagni, « Bard, la réponse de Google à ChatGPT »

, sur www.science-et-vie.com, (consulté le )

, sur www.science-et-vie.com, (consulté le )

- ↑ (en) Sissie Hsiao, « Bard gets its biggest upgrade yet with Gemini »

, sur Google, (consulté le )

, sur Google, (consulté le )

- ↑ Victor Lafosse-Barthès, « Google sort Gemini (par surprise) et annonce surpasser GPT-4 d'OpenAI », sur Ariel World, (consulté le )

- ↑ (en-US) « Bard becomes Gemini: Try Ultra 1.0 and a new mobile app today », sur Google, (consulté le )

- ↑ Carla Plomb, «C’est totalement inacceptable» : après les dérapages de son IA Gemini, le PDG de Google recadre ses équipes, lefigaro.fr, 28 février 2024

- ↑ IA : le patron de Google reconnaît les erreurs « totalement inacceptables » de Gemini, latribune.fr, 28 février 2024

- ↑ « Google introduit les Gems pour personnaliser l’IA Gemini et le générateur Imagen 3 », Cnet France, (lire en ligne).

- ↑ (en) « Why AI Developers Are Skipping Google's Gemini », The Information, (lire en ligne)

- ↑ (en-US) « Gemini 2.5: Our most intelligent AI model », sur Google, (consulté le )

Voir aussi

Articles connexes

- Agent conversationnel

- Apprentissage par renforcement

- Apprentissage supervisé

- Grand modèle de langage

- Intelligence artificielle digne de confiance

Liens externes

- Site officiel

- Qu'est-ce que l'IA Gemini qui quintuple GPT4 ? sur Dataconomy (12 septembre 2023)

- L'IA Gemini de Google sur Digitiz (15 septembre 2023)

- Google Gemini, une IA plus puissante que GPT-4 sur ZDNet (20 septembre 2023)

- Google Gemini, l'intelligence artificielle qui promet de révolutionner l'IA sur 01net (25 septembre 2023)

Six mois après sa mise à disposition pour le grand public, ChatGPT a suscité de nombreuses réactions. Bien que l’on parle de l’intelligence artificielle (IA) en éducation depuis un certain temps (Holmes et Tuomi, 2022), il s’agit probablement du premier outil à vraiment faire son entrée dans les salles de classe. Au cours de ce webinaire, nous présenterons les principales caractéristiques de l’outil et des outils similaires, les implications potentielles pour l’éducation, en particulier en ce qui concerne le plagiat, mais également ses potentiels pédagogiques.

Rediffusion du webinaire

Support de communication du webinaire

| 🌐 Source |

|---|

| https://crifpe.ca/activites/1844 |

L’intelligence artificielle (IA) a tout le potentiel pour relever certains des plus grands défis liés à l’éducation du XXIe siècle, pour innover dans les pratiques d’enseignement et d’apprentissage et, en dernière instance, pour accélérer les progrès vers l’ODD 4. Cependant, et de manière inévitable, ces développements technologiques rapides entraînent de multiples risques et défis, qui ont jusqu’à présent dépassé les débats politiques et les cadres réglementaires.

Cette publication offre des conseils aux décideurs politiques sur la meilleure façon de tirer parti des opportunités et de faire face aux risques présentés par les liens de plus en plus étroits qui unissent l’IA et l’éducation.

Elle s’ouvre avec les éléments essentiels de l’IA : définitions, techniques et technologies. Elle se poursuit avec une analyse détaillée des tendances émergentes et des implications de l’IA sur l’enseignement et l’apprentissage, y compris la manière dont nous pouvons garantir l’utilisation éthique, inclusive et équitable de l’IA dans le champ éducatif, comment l’éducation peut préparer les humains à vivre et à travailler avec l’IA, et comment l’IA peut être mise en œuvre en vue d’améliorer l’éducation. Elle termine avec les défis que représente l’exploitation de l’IA pour atteindre l’ODD 4 et propose des recommandations concrètes et exploitables à l’intention des décideurs pour les aider à planifier des politiques et des programmes adaptés aux contextes locaux.

Document publié par l’UNESCO en 2021 puis traduit en français en 2023.

Voir aussi l’évènement de lancement rediffusé en ligne :

⭐ Évaluation collective

| 🤖 Fonctionnalités | |

| 📱 Utilisabilité | |

| 🛡️Sécurité | |

| 💰 Prix | |

| 🎓 Alignement pédagogique | |

| 🐣 Maturité | |

|

Moyenne

|

|

|

|

![]()

🗨️ Vos retours libres

📢 On en parle sur l’ObsiaFormation

Comparatif d’outils d’IA génératives

Ce petit comparatif a pour objectif de faire un très rapide état des lieux des principaux outils d’IA génératives à…

📰 Actualités récentes depuis la source

🗓️ 15 septembre 2025 ⌚ 0h00

Claude is now generally available in Xcode

🗓️ 15 septembre 2025 ⌚ 0h00

Anthropic Economic Index: Tracking AI’s role in the US and global economy

🗓️ 27 août 2025 ⌚ 0h00

Detecting and countering misuse of AI: August 2025

🗓️ 20 août 2025 ⌚ 0h00

Claude Code and new admin controls for business plans

🗓️ 6 août 2025 ⌚ 0h00

Anthropic appoints Hidetoshi Tojo as Head of Japan and announces hiring plans

🗓️ 6 août 2025 ⌚ 0h00

Automate security reviews with Claude Code

🗓️ 21 juillet 2025 ⌚ 0h00

Anthropic to sign the EU Code of Practice

🗓️ 15 juillet 2025 ⌚ 0h00

Paul Smith to join Anthropic as Chief Commercial Officer

🗓️ 14 juillet 2025 ⌚ 0h00

Anthropic and the Department of Defense to advance responsible AI in defense operations

🗓️ 7 juin 2025 ⌚ 0h00

National security expert Richard Fontaine appointed to Anthropic’s long-term benefit trust

🗓️ 28 mai 2025 ⌚ 0h00

Reed Hastings appointed to Anthropic’s board of directors

🗓️ 22 mai 2025 ⌚ 0h00

New capabilities for building agents on the Anthropic API

🗓️ 8 avril 2025 ⌚ 0h00

Anthropic appoints Guillaume Princen as Head of EMEA and announces 100+ new roles across the region

ℹ️ Plus d’infos via Wikipédia

Claude (modèle de langage)

| Développé par | Anthropic |

|---|---|

| Première version | |

| Dernière version | Claude 4.0 () |

| Type | Famille de grands modèles de langage |